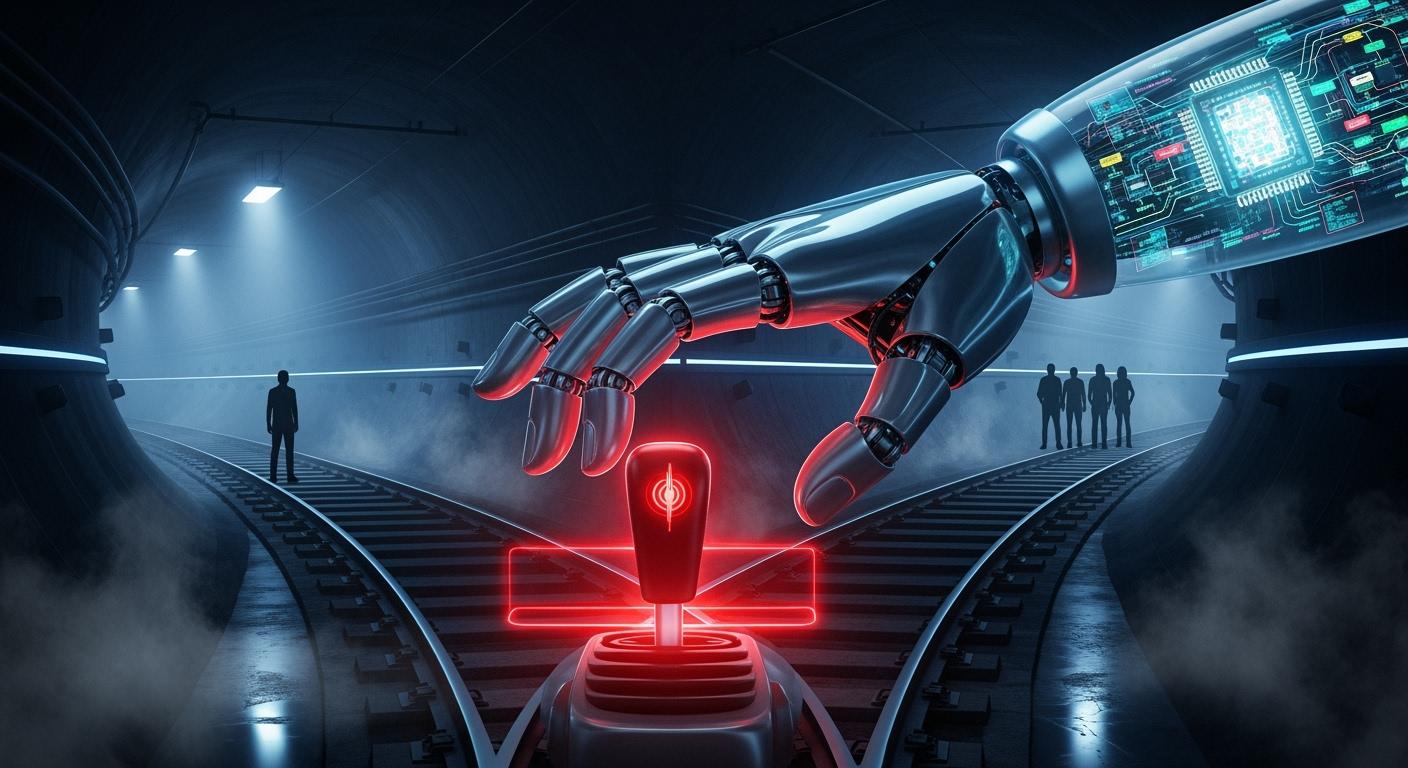

AI的致命抉擇:當自駕車的「謀殺演算法」駛入道德與法律的十字路口

當我們將方向盤交給人工智慧(AI)的那一刻,我們不僅是在擁抱一項革命性的便利科技,更是在無形中啟動了一場深刻的倫理與法律辯論。自動駕駛汽車承諾了一個更安全、更高效的未來交通樣貌,然而,當事故的發生無可避免時,一個冰冷而尖銳的問題浮現:自駕車該如何做出攸關生死的決定?這便是著名的「電車難題」在數位時代的殘酷變奏,其核心在於一個被稱為「謀殺演算法」(Murder Algorithm)的程式碼,以及其背後千絲萬縷的責任歸屬。

電車難題的數位輪迴:演算法如何學會「選擇」犧牲?

古典的電車難題,要求一個人在犧牲少數與犧牲多數之間做出抉擇,這是一個挑戰人類道德直覺的思想實驗。 當這個難題被移植到自駕車上,它便不再是紙上談兵的哲學思辨,而是工程師必須在程式碼中寫下的現實指令。 想像一個場景:一輛高速行駛的自駕車煞車突然失靈,前方是五個正在過馬路的行人;如果緊急轉向,則會撞上路邊的一位行人。AI應該如何選擇?是犧牲一人拯救五人,還是維持原路線,不主動「謀殺」任何人?

為了解答這個問題,麻省理工學院(MIT)發起了名為「道德機器」(Moral Machine)的大規模全球實驗。 該計畫透過網路平台,收集了來自全球數百萬人、多達4000萬次的道德決策,試圖描繪出人類在面對這類困境時的集體道德偏好。 研究結果揭示了一些跨文化的普遍傾向,例如:

- 保護人類優於動物。

- 拯救更多生命優於較少生命。

- 優先保護兒童而非長者。

然而,實驗也凸顯了顯著的文化差異。例如,來自東方文化群體的參與者更傾向於保護守法的行人,而西方國家的參與者則更傾向於不採取任何行動,讓車輛維持原定路線。 這些分歧恰恰暴露了設計一套「全球通用」道德演算法的根本困境:誰的道德標準應該成為普世標準?

「謀殺演算法」的設計哲學:效益主義 vs. 義務論

在程式碼的背後,是兩種主要的倫理學框架在角力:

- 效益主義 (Utilitarianism):這種觀點主張,最道德的選擇是能夠最大化總體福祉、將傷害降至最低的選擇。 按照這個邏輯,自駕車應該毫不猶豫地選擇撞向一個人,以拯救五個人,因為「五大於一」。 這也是「道德機器」實驗中多數人的直覺反應。 然而,純粹的效益主義會引發令人不安的結論:為了保護車內多名乘客,是否就應該犧牲一位無辜的路人?甚至,車輛是否應該根據社會地位、年齡等因素計算生命的「價值」?

- 義務論 (Deontology):與效益主義相對,義務論強調行為本身的道德正當性,而非其結果。德國的《自動駕駛倫理委員會》報告便體現了此原則,明確規定演算法必須優先保護人類生命,但絕對禁止根據年齡、性別或殘疾等個人特徵進行差別對待。 換言之,生命是平等的,不能被量化計算。Google在早期處理此問題時,也採取了類似的義務論策略:無論如何只選擇撞擊體積較小的物體,而不去區分那是垃圾桶還是嬰兒車。 這種方法的優點是避免了對生命進行價值排序的道德滑坡,但可能導致更大多數的傷亡。

更有甚者,一些車廠如賓士曾提出優先保護車上乘客的設定,這雖然可能迎合了車主的自保心態,卻引發了巨大的倫理爭議。 這也引出了一個更複雜的選項:是否應該讓消費者自行選擇他們車輛的「道德設定」? 這看似賦予了使用者權力,但實際上是將沉重的道德責任轉嫁給了個人。

當演算法犯錯:責任的迷霧該如何廓清?

當悲劇發生,最現實的問題隨之而來:誰該負責?傳統交通事故的責任歸屬相對明確,通常指向駕駛人。 但在自駕車的世界裡,方向盤後的「駕駛」可能只是個名義上的監督者,甚至是缺席的。責任的鏈條變得異常複雜,可能牽涉到以下多方:

- 車輛所有人/管理人:在現行的許多法規草案中,例如中國北京和深圳的規定,當車輛在自動駕駛模式下發生事故,所有人或管理人通常被視為第一賠償責任人。 他們有義務對車輛進行妥善維護和系統更新。

- 汽車製造商與軟體開發商:如果事故源於硬體故障、感測器失靈或演算法本身的設計瑕疵,那麼製造商和軟體公司(如特斯拉)顯然難辭其咎。 這涉及到《產品品質法》的範疇,製造商需承擔嚴格的「嚴格責任」。

- 人類駕駛:在尚未達到完全自動駕駛(SAE Level 5)的階段,駕駛人仍負有監督和隨時接管車輛的注意義務。 特斯拉的「完全自動駕駛」(FSD)系統雖然名為完全,但實際上仍要求駕駛人保持警惕,因此發生事故時,駕駛人仍可能需要承擔責任。

- 技術監管人:德國的《2021自動駕駛法案》引入了「技術監管人」的概念,這類主體需要對車輛的運行進行監督,並承擔相應的法律責任。

目前,全球尚未形成統一的法律規範。德國開創性地提出,在L4級以上的自動駕駛事故中,駕駛人原則上不再承擔責任,轉而追究車輛保有人和生產者的無過錯責任。 而在台灣,相關法規仍在探討階段,從民法中的推定過失責任到消費者保護法的嚴格責任,都可能成為認定標準。 這種法律上的不確定性,正反映了科技發展速度已超越法律建構的現實。

結論:在科技與人性之間尋找平衡

AI版的電車難題,不僅僅是一道技術題,更是一道深刻的社會題。它逼迫我們去直視那些在日常生活中被模糊處理的道德直覺與價值判斷。設計「謀殺演算法」,並非是為了創造一個冷血的殺人機器,而是在不可避免的傷害中,尋找一個最不壞的選擇。

或許,最終的答案並非一個單一的、放諸四海皆準的演算法。我們需要的可能是一個透明、可解釋,且經過充分社會討論的決策框架。台灣已有研究團隊嘗試透過「演化計算」等方式,讓AI模擬出更接近人類共識的道德判斷。

在法律層面,建立一個清晰的責任分配機制與保險理賠制度至關重要。這不僅能保障受害者的權益,也能為製造商和消費者提供明確的行為預期,從而推動自駕技術的健康發展。

自動駕駛的未來,不應僅僅是工程師的閉門造車,更需要哲學家、法律專家、政策制定者乃至每一位社會公民的共同參與。 因為當AI駛上街頭,它所承載的,不僅是乘客,更是我們整個社會對於生命、道德與責任的集體共識。在這條通往未來的道路上,我們必須謹慎地編寫每一行程式碼,因為它定義的,將不僅是機器的行為,更是我們的人性本身。